Statistik für die Vorhersage von Schneefall

Die Qualität von Wetterberichten hat sich mit der Entwicklung immer leistungsfähigerer Computermethoden in den vergangenen Jahrzehnten stark verbessert. Die Vorhersagezeiträume sind länger und die Prognosen genauer geworden. Bei komplexen lokalen Gegebenheiten kommen allerdings auch die gängigen Wettermodelle an ihre Grenzen. Für Gebiete von hunderten Quadratkilometern Größe gibt es in der Regel nur eine einzige Vorhersage, was gerade in Gebirgsregionen zu großen Ungenauigkeiten führt. Das hat vielerlei Konsequenzen, insbesondere, wenn es um Schneemengen geht, die für den Tourismus große Bedeutung haben. Das Thema Sicherheit ist hier besonders relevant. Eine in Innsbruck tätige Forschungsgruppe aus den Gebieten Meteorologie und Statistik hat nun in einem vom Wissenschaftsfonds FWF finanzierten Projekt die Daten von konventionellen Wettermodellen mit lokalen Messungen aus der Vergangenheit verglichen, um so lokal präzisere Vorhersagen zu erhalten, und zwar speziell für Schneefall.

Das Wetter in der Vergangenheit einbeziehen

„In globalen numerischen Wettersimulationen, wie sie für Wetterberichte verwendet werden, werden relativ große Zellen modelliert, 20 mal 20, manchmal 50 mal 50 Kilometer“, erklärt Projektleiter Achim Zeileis im Gespräch mit scilog. „Doch wer in Tirol aus dem Fenster blickt, kann mit freiem Auge sehen, dass sich das Wetter auf 20 Kilometern mehrmals ändert, unter anderem weil Berge im Weg stehen, die in dem numerischen Modell so nicht abgebildet sind.“ Die exakte physikalische Modellierung solcher lokalen Eigenheiten des Wetters sei praktisch unmöglich, sagt Zeileis. Allerdings gebe es viele lokale Messstationen, die genauere Auskünfte darüber erlauben, wie das Wetter in der Vergangenheit war. Diese ließen sich nutzen, um konventionelle Wettervorhersagen lokal zu korrigieren.

„Wir sammeln und kombinieren Wetterdaten aus der Vergangenheit, um zu verstehen, wie das Wetter wirklich war, wenn numerische Wettersimulationen eine bestimmte Vorhersage machten“, erklärt Zeileis. „War es tendenziell wärmer oder kälter, hat es mehr oder weniger geregnet als vorhergesagt?“ In der Forschung spricht man von „standardisierten Anomalien“. – Man versucht, immer wieder auftretende Abweichungen statistisch zu fassen und die Vorhersagen so lokal anzupassen. „Diese Prognosen sind natürlich nach wie vor fehlerbehaftet, zum Teil mit deutlichen Fehlern, sie sind aber häufig sehr viel besser als das, was die konventionellen Wettermodelle ausspucken“, erklärt Zeileis.

Verschiedene Daten zusammengeführt

Für die Schneevorhersage sei das Verarbeiten der Messdaten durchaus kompliziert gewesen, erklärt Projektmitarbeiter Reto Stauffer, der sein Doktorat im Laufe des Forschungsprojekts abschloss. Für die Vorhersage von Schnee brauche es sowohl Informationen über die Temperatur als auch über den Niederschlag. „Wir hatten viele verschiedene Datenquellen zur Verfügung. Für die Vorhersage von Schneemengen war besonders wichtig, dass wir lange Zeitreihen hatten, weil Niederschlag sehr variabel ist. Ein oder zwei Jahre genügen da nicht.“ Man habe sich darauf konzentriert, die Temperaturmessungen und die Niederschlagsmessungen aus zwei verschiedenen Messnetzen zu beziehen, und zwar Letztere vom Hydrographischen Dienst, weil diese Daten vierzig oder fünfzig Jahre in die Vergangenheit reichen, während Erstere vom nationalen Wetterdienst stammen, der sehr viele Stationen besitzt. „Da reichte es, Daten zu haben, die zehn oder fünfzehn Jahre in die Vergangenheit gehen.“ Als numerisches Wettermodell nutzte man verschiedene Produkte des Europäischen Zentrums für Wettervorhersage, unter anderem eines, das eigentlich für Klimatologie konzipiert ist und präzise Schätzungen für den Niederschlag erlaubt. Für die Arbeit war es dabei nicht nötig, Genaueres über die physikalischen Vorgänge am jeweiligen Ort zu wissen. Eine Einbeziehung physikalischer Variablen habe man zwar versucht, beispielsweise die Ausrichtung des Hangs. Für die Prognose habe das aber nur wenig gebracht.

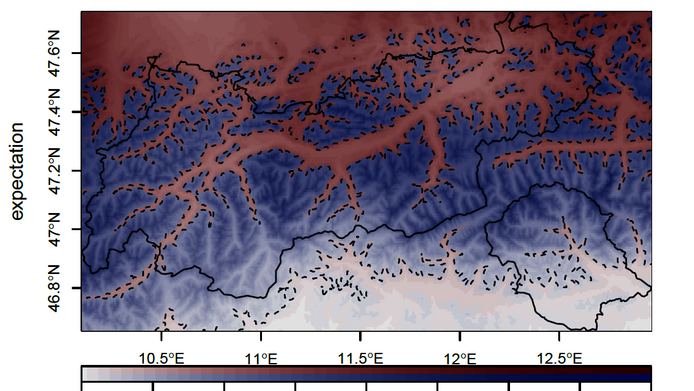

Fokus auf Tirol

Für die Berechnung der Schneemengen konzentrierten sich die Forscherinnen und Forscher auf Tirol. Zeileis betont, dass diese Arbeiten besonders für Gebirgsregionen interessant seien: „In Flachland-Gegenden gibt es keine so großen Fehler in den globalen Wettersimulationen, weil sich das Gelände hier weniger ändert.“ Bei anderen Projekten habe man sich unter anderem Südtirol angesehen. Achim Zeileis betont, dass es sich um Grundlagenforschung handelte, obwohl das Thema von großem gesellschaftlichem Interesse sei. Das von seiner Gruppe entwickelte statistische Modell, das mit den genannten standardisierten Anomalien arbeitet, wird an einigen Stellen bereits praktisch eingesetzt. Die Vorhersageverfahren für Schneemengen wurden erst kürzlich publiziert. „Wir haben hier ein flexibles Werkzeug, das in Zukunft für verschiedene praktische Anwendungen relevant sein kann“, sagt Zeileis.

Zur Person

Achim Zeileis ist Professor am Institut für Statistik der Universität Innsbruck. Der Statistiker interessiert sich besonders für Wettervorhersagen, Statistische Modellierung, Software für Statistik und Machine Learning.

Publikationen

Reto Stauffer, Georg J. Mayr, Jakob W. Messner, Achim Zeileis: Hourly Probabilistic Snow Forecasts over Complex Terrain: A Hybrid Ensemble Postprocessing Approach. Advances in Statistical Climatology, Meteorology and Oceanography, accepted for publication, 2018

Markus Dabernig, Georg J. Mayr, Jakob W. Messner, Achim Zeileis: Spatial Ensemble Post-Processing with Standardized Anomalies. Quarterly Journal of the Royal Meteorological Society, 2017

Reto Stauffer, Nikolaus Umlauf, Jakob W. Messner, Georg J. Mayr, Achim Zeileis: Ensemble Post-Processing of Daily Precipitation Sums over Complex Terrain Using Censored High-Resolution Standardized Anomalies. Monthly Weather Review, 2017

Jakob W. Messner, Georg J. Mayr, Achim Zeileis: Heteroscedastic Censored and Truncated Regression with crch. The R Journal, 2016 (pdf)