Licht in Datendschungel bringen

Mehr ist nicht immer mehr. Den Eindruck gewinnt man, wenn Gregor Kastner sein Arbeitsgebiet erklärt. „Ich bin vorsichtig mit dem Begriff Big Data“, erklärt der Forscher. Mehr Daten machen uns nicht in jedem Fall schlauer, es komme auf die Fragestellung an. „Wenn ich die Fragestellung einfach halte, dann wird es durch mehr Daten einfacher, die Frage zu beantworten. Aber mit mehr Daten steigt meist auch die Anzahl der Fragen. Dann ist es schwierig, das zu finden, was uns eigentlich interessiert. Eigentlich brauchen wir so etwas wie eine Schatzkarte.“ Wie man solche Schatzkarten zeichnet, ist das Ziel eines Projekts des Technischen Mathematikers Kastner. Es ist eines der ersten sogenannten Zukunftskollegs des Wissenschaftsfonds FWF. Dieses Förderprogramm richtet sich an junge Forschende kurz nach dem Doktorat und soll unterschiedlichen Fachrichtungen zusammenbringen. In diesem Fall sind es mit Kastner fünf Personen aus Statistik, Machine Learning, Ökonomie, sowie Sozial- und Computerwissenschaften. Sie interessieren sich für Wirtschafts- und Nachhaltigkeitsfragen. Eines ihrer aktuellen Betätigungsfelder ist die Corona-Pandemie.

Relevante Daten finden

Von der Gefahr, nicht zu wenige, sondern zu viele Daten zu sammeln, ist in letzter Zeit immer wieder die Rede. Doch was macht es eigentlich schwierig, viele Daten zu haben und komplexe Modelle darauf anzuwenden? Ein laut Kastner vermehrt auftretendes Problem nennt sich im Englischen „Overfitting“. Damit ist der paradoxe Umstand gemeint, dass ein Modell nicht zu gut sein darf, um glaubwürdig zu sein. Dieses Problem wächst bei besonders flexiblen Modellen und das verwendete Modell verliert seine Aussagekraft, vergleichbar mit einem Schlüssel, der in eine weiche Masse gedrückt wird. Dass der Schlüssel sich hineindrücken lässt, liegt nicht daran, dass er passt, sondern dass die Masse zu weich ist. „In hunderttausenddimensionalen Räumen sind selbst Milliarden an Datenpunkten nichts wert, die verlieren sich, wenn die richtige Struktur fehlt“, wie es Kastner erklärt. Es sei also wichtig, die relevanten Daten von den irrelevanten zu unterscheiden. Mathematisch bedeutet das, man versucht, einen hochdimensionalen Raum in einen geeigneten niedrigdimensionalen einzubetten. „Der einfachste Fall wäre, dass man gewisse Daten ignoriert“, sagt Kastner. „Es gibt aber interessantere, effektivere Möglichkeiten.“ Er spricht davon, dass manchmal Kombinationen großer Mengen von Einzeldaten dieselbe Information beinhalten wie die Daten selbst, aber einfacher zu verarbeiten seien. Dabei helfen spezielle Vorannahmen, sogenannte Apriori-Verteilungen, die speziell auf die Problemstellung abgestimmt sind.

Dunkelziffer bei Covid

Eine Anwendungsmöglichkeit dieser abstrakten Konzepte fand Kastners Team in der aktuellen Covid-19-Krise. Man versuchte schon vor einigen Monaten, die Dunkelziffer an Infizierten abzuschätzen und nutzte dafür Testdaten vom April dieses Jahres aus Island, weil dort früher als anderswo breit getestet wurde und nicht nur beim Auftreten von Symptomen. Die Arbeit sei eigentlich nur ein kurzfristig veröffentlichtes Nebenergebnis gewesen, das aber durch die aktuelle Lage Aufmerksamkeit erregt hat. Das Ergebnis war, laut Kastner, vor allem die hohe Unsicherheit: „Wir konnten sehen, dass es noch nicht seriös war, einen genauen Wert zu liefern, sondern nur Wahrscheinlichkeiten mit einer hohen Unsicherheit, was bei Pressevertretern eine gewisse Frustration ausgelöst hat.“ Im Mittel war die Dunkelziffer um 8,35 Mal höher als die Zahl der diagnostizierten Infektionen, doch die Schwankungsbreite hing stark von der verwendeten statistischen Methode ab. Man betonte deshalb die Notwendigkeit von Screenings, also breit gestreuten Tests in der Bevölkerung, wie sie später in Österreich auch durchgeführt wurden. In einer weiteren Arbeit, die zur Veröffentlichung eingereicht wurde, untersucht das Team nun die wirtschaftlichen Auswirkungen der Covid-19-Krise.

Lernen mit Computern

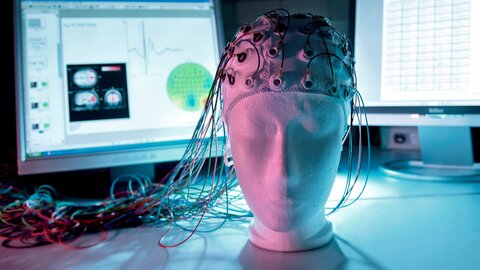

Bei ihrer Arbeit nutzt die Gruppe um Kastner unter anderem Methoden der künstlichen Intelligenz, Machine Learning genannt. Manche Standardmethoden des Computerlernens, wie sie heute standardmäßig in vielen Bereichen, etwa für Gesichtserkennung, eingesetzt werden, werden zum Teil kritisch gesehen, weil sie üblicherweise zwar ein bestimmtes Problem lösen können, aber keinen Einblick in die Zusammenhänge und Mechanismen erlauben, wie sie das tun. Das behindert auch die Fehlerabschätzung. Kastner betont, dass der Bereich Statistical Learning, in dem er aktiv ist, hier bessere Möglichkeiten bietet: „Für mich persönlich wichtig ist: Im Statistical Learning setzen wir uns sehr mit der Unsicherheit auseinander.“ Viele der Modelle seien außerdem recht einfach interpretierbar, man könne in den Algorithmus hineinschauen und etwas über das untersuchte System lernen. „Es geht nicht nur um die Vorhersage, sondern wir betreiben Datenfernsehen und können strukturell verstehen, was vor sich geht“, so der Mathematiker.

Die gleiche Sprache sprechen

Die Besonderheit an den „Zukunftskollegs“, des neuen Programms des FWF, ist die Interdisziplinarität und die Konzentration auf junge Forschende ein bis maximal fünf Jahre nach dem Doktorat. Das bringe ganz eigene Herausforderungen, erzählt Projektleiter Kastner. „Eine ist die Kommunikation. Wir haben mehr oder weniger drei bis vier Fachgebiete, die zusammenkommen, und alle verwenden eine unterschiedliche Terminologie.“ Wie man die Dinge nenne, sei eigentlich Schall und Rauch, sagt Gregor Kastner. Niemand habe ein Problem damit, seine Terminologie anzupassen. „Dennoch identifizieren wir uns stark mit bestimmten Begriffen“, betont der Forscher. Dazu komme, dass der Fokus verschiedener Disziplinen unterschiedlich sei. Kastner betont aber auch die Vorteile des interdisziplinären Zugangs: „Wenn es in Richtung Anwendung geht, ist man als Statistiker gesegnet, wenn man Daten aus unterschiedlichen Feldern bekommt.“ Es gehe darum, die Anwendung von statistischen Methoden, die für einen bestimmten Bereich entwickelt wurden, auf andere Bereiche zu übertragen. Das Projekt „Hochdimensionales statistisches Lernen: Neue Methoden für Wirtschafts- und Nachhaltigkeitspolitik“ ist auf vier Jahre ausgelegt und läuft noch bis 2023.

Neue Chancen für Nachwuchstalente

Mit den Zukunftskollegs fördert der Wissenschaftsfonds FWF in Kooperation mit der Österreichischen Akademie der Wissenschaften ÖAW seit 2018 exzellente Nachwuchsforschung in Österreich. Interdisziplinarität, innovative Forschungsansätze und Vernetzung stehen im Fokus dieses Programms.

Zur Person

Gregor Kastner forscht derzeit an der Wirtschaftsuniversität Wien und ist ab Oktober 2020 Professor für Statistik an der Universität Klagenfurt. Er interessiert sich für die Bayesianische Modellierung von Zeitreihen verschiedenster Art, etwa Aktienkursen. Dabei beschäftigt er sich sowohl mit den Grundlagen als auch mit der Entwicklung von Softwaretools.

Publikationen

Hirk, Rainer; Kastner, Gregor; Vana, Laura: Investigating the Dark Figure of COVID-19 Cases in Austria: Borrowing From the Decode Genetics Study in Iceland, in: Austrian Journal of Statistics, 49 (5). 2020

Kastner, G, Huber, F.: Sparse Bayesian vector autoregressions in huge dimensions, in: Journal of Forecasting, 1-24, 2020

Gregor Kastner: Sparse Bayesian time-varying covariance estimation in many dimensions, in: Journal of Econometrics, Vol. 210, Issue 1, 2019