Die besten falschen Modelle finden

„Alle Modelle sind falsch, aber manche sind nützlich.“ So zitiert Gregor Kastner den britischen Statistiker George E. P. Box und fasst damit einen wichtigen Aspekt seiner eigenen Forschung zusammen. Kastner leitet als Professor für Statistik an der Universität Klagenfurt das interdisziplinäre Zukunftskolleg „Hochdimensionales statistisches Lernen: Neue Methoden für Wirtschafts- und Nachhaltigkeitspolitik“ des Wissenschaftsfonds FWF, in dem er mit Ökonom:innen, Computerwissenschaftler:innen und Nachhaltigkeitsforscher:innen zusammenarbeitet. Das Projekt startete 2019 und umfasst neben seinem Team an der Universität Klagenfurt Forschende an der Universität Salzburg, am Österreichischen Institut für Wirtschaftsforschung (WIFO) und an der Technischen Universität Wien.

Dabei geht es darum, die statistischen Modelle, die für Vorhersagen in vielen verschiedenen Bereichen der Wirtschaft genutzt werden, grundlegend zu verbessern. Kastner erklärt das Eingangszitat: „Modelle können nie die gesamte Wirklichkeit abbilden. Sie können nur möglichst gut für den jeweiligen Anwendungsfall sein und uns damit Vorhersagen und Wahrscheinlichkeiten liefern, die uns helfen, Entscheidungen zu treffen.“

Der Fluch der Dimensionalität

Statistische Modelle kann man sich vereinfacht als eine Ansammlung von mathematischen Formeln vorstellen, denen man – wenn sie gut gemacht sind – Daten in Form von Zahlen füttern kann, und die dann Vorhersagen über die Zukunft ausspucken und abschätzen, wie wahrscheinlich diese zutreffen. Zum Beispiel gibt es Modelle, die unter anderem versuchen vorherzusagen, wie sich das Wirtschaftswachstum eines Landes durch die Änderung des Leitzinses verändern wird. Dabei spielt aber nicht nur der Wert des Leitzinses eine Rolle, sondern auch eine Vielzahl anderer wirtschaftlicher Faktoren, die das Modell, so gut es geht und sinnvoll ist, erfassen muss.

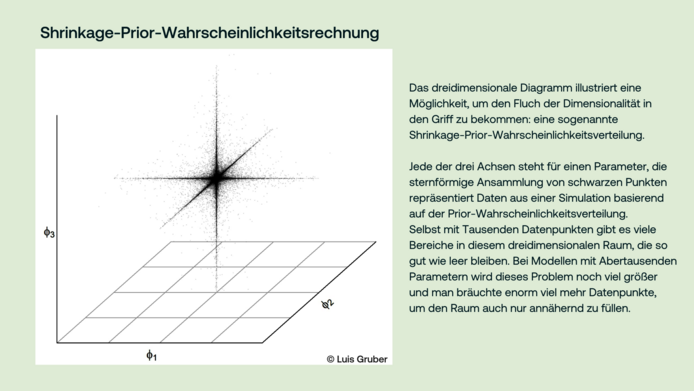

So ein statistisches Modell kann auf viele verschiedene Arten erstellt werden. Es muss mittels Daten aus der echten Welt trainiert und getestet werden. Eine einfache Art, wie man die Komplexität eines Modells darstellen kann, ist die Anzahl seiner Parameter. Im obigen Beispiel ist der Einfluss des Leitzinses einer der Parameter, aber es kommen – neben vielen anderen – auch Faktoren wie die Arbeitslosenquote, die Produktivität verschiedener Wirtschaftszweige oder zyklische Ereignisse ins Spiel. Um möglichst korrekte Voraussagen zu machen, braucht ein Modell aber noch viel mehr Parameter. Durch die Komplexität der Daten kann ein Modell damit Zehn- bis Hunderttausende Parameter umfassen.

„Das Problem dabei ist der Fluch der Dimensionalität“, erklärt Kastner. „Vereinfacht gesagt, entspricht die Dimensionalität eines Modells der Anzahl der Parameter. Der Fluch dabei ist, dass bei zu vielen Parametern die vorhandenen Daten schnell zu wenig werden, um ein gutes Modell darauf aufzubauen.“ Wenn nämlich zu wenig Daten bei zu vielen Parametern vorhanden sind, tendiert das Modell dazu, fälschlich einfach die vorhandenen Daten für Voraussagen übergenau zu reproduzieren. „Das Modell kann dadurch die zugrunde liegenden Trends und Zusammenhänge nicht darstellen und produziert verzerrte, ungenaue oder übergenaue Aussagen über die Zukunft“, fügt Kastner hinzu.

Gregor Kastner ist Professor für Statistik und Vorstand des Instituts für Statistik an der Universität Klagenfurt.

Mehr zum Projekt: https://zk35.org/

Modelle für Finanzwirtschaft und Standortdaten

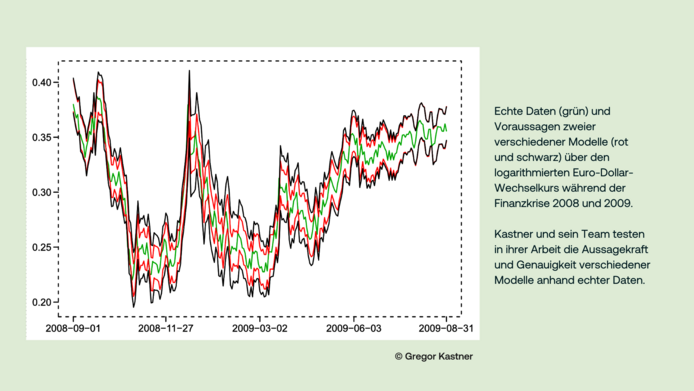

Diesen Fluch der Dimensionalität zu bannen, ist ein zentraler Fokus von Kastners Projekt. „Wir haben makroökonomische Daten und Kursvolatilität in der Finanzwirtschaft modelliert, uns Satellitendaten zur landwirtschaftlichen Flächennutzung und zu deren Zusammenhang mit EU-Förderungen angesehen und untersucht, wie man mit der anonymisierten Aktivität von Mobiltelefonen Personen- und Verkehrsdichten modellieren und vorhersagen kann“, umreißt Kastner einige der untersuchten Anwendungsfelder hochdimensionaler statistischer Modelle.

Dabei ging es den Forschenden aber weniger darum, konkrete Empfehlungen für politische Entscheidungen zu produzieren, sondern die zugrunde liegenden Modelle robuster zu machen. „Wir nutzen verschiedene Ansätze, um die Aussagekraft der Modelle zu verbessern, insbesondere Methoden aus der sogenannten Bayes-Statistik, was erst in den letzten Jahrzehnten durch die enorm gesteigerte Leistung von Computern möglich wurde“, sagt Kastner. „Damit möchten wir eine stabile Grundlage für statistische Modelle bieten, die in vielen Bereichen Anwendung finden können – wie zum Beispiel auch beim gegenwärtig viel diskutierten maschinellen Lernen, das oft noch mit Fehlern kämpft.“

Blick zurück und in die Zukunft

Mitte 2024 geht das Forschungsprojekt zu Ende und Kastner blickt mit Freude auf die gelungene Zusammenarbeit zurück: „Es galt einige Herausforderungen zu meistern, insbesondere die Kommunikation zwischen den verschiedenen Fachdisziplinen. Manche Begriffe bedeuten in zwei Fachbereichen einfach verschiedene Dinge. Insgesamt war das Projekt jedoch ein großer Erfolg. Wir haben nicht nur die Wissenschaft vorangebracht, sondern konnten durch die Fördermittel auch die Arbeit zahlreicher Forschender finanzieren, um auf ihrem Gebiet voranzukommen.“ Die meisten der Jungwissenschaftler:innen, die das Projekt ursprünglich eingereicht hatten, fanden weitere dauerhafte Anstellungen in der Wissenschaft – zwei davon sogar eine Professur.

„Die Förderung des FWF hat dabei eine entscheidende Rolle gespielt. Die Zukunft wird zeigen, welche der Resultate nachhaltig Anwendung finden werden“, so Kastner. „Mich selbst wird die Suche nach der Wahrheit in Modellen auf jeden Fall weiter begleiten.“

Zur Person

Gregor Kastner ist Professor für Statistik und Vorstand des Instituts für Statistik an der Universität Klagenfurt. Nach Studien in Technischer Mathematik, Computerwissenschaften und Sport und einer Zeit als Schullehrer fand er 2010 zur Bayes-Statistik und promovierte dazu 2014. Seit 2020 hat er die Professur an der Universität Klagenfurt inne und freut sich, seiner Leidenschaft für Statistik, insbesondere für die bayesianische Modellierung, nachgehen und andere Forschende in ihrer Arbeit anleiten und unterstützen zu können. Das Projekt Hochdimensionales statistisches Lernen: Neue Methoden für Wirtschafts- und Nachhaltigkeitspolitik (2019–2024) wurde vom Wissenschaftsfonds FWF im Rahmen des Programms „Zukunftskollegs“ zur Förderung innovativer und interdisziplinärer Kooperation von Postdoc-Teams mit rund zwei Millionen Euro gefördert.

Publikationen

Feldkircher M., Gruber L., Huber F., Kastner G.: Sophisticated and small versus simple and sizeable: When does it pay off to introduce drifting coefficients in Bayesian vector autoregressions? Journal of Forecasting 2024

Vana L., Visconti E., Nenzi L., Cadonna A., Kastner G.: Bayesian Machine Learning meets Formal Methods: An application to spatio-temporal data. arXiv pre-print 2024

Gruber L., Kastner G.: Forecasting macroeconomic data with Bayesian VARs: Sparse or dense? It depends! arXiv pre-print 2023

Mozdzen A., Cremaschi A., Cadonna A. et al: Bayesian modeling and clustering for spatio-temporal areal data: An application to Italian unemployment. Spatial Statistics, Vol. 52, 2022